一、简介

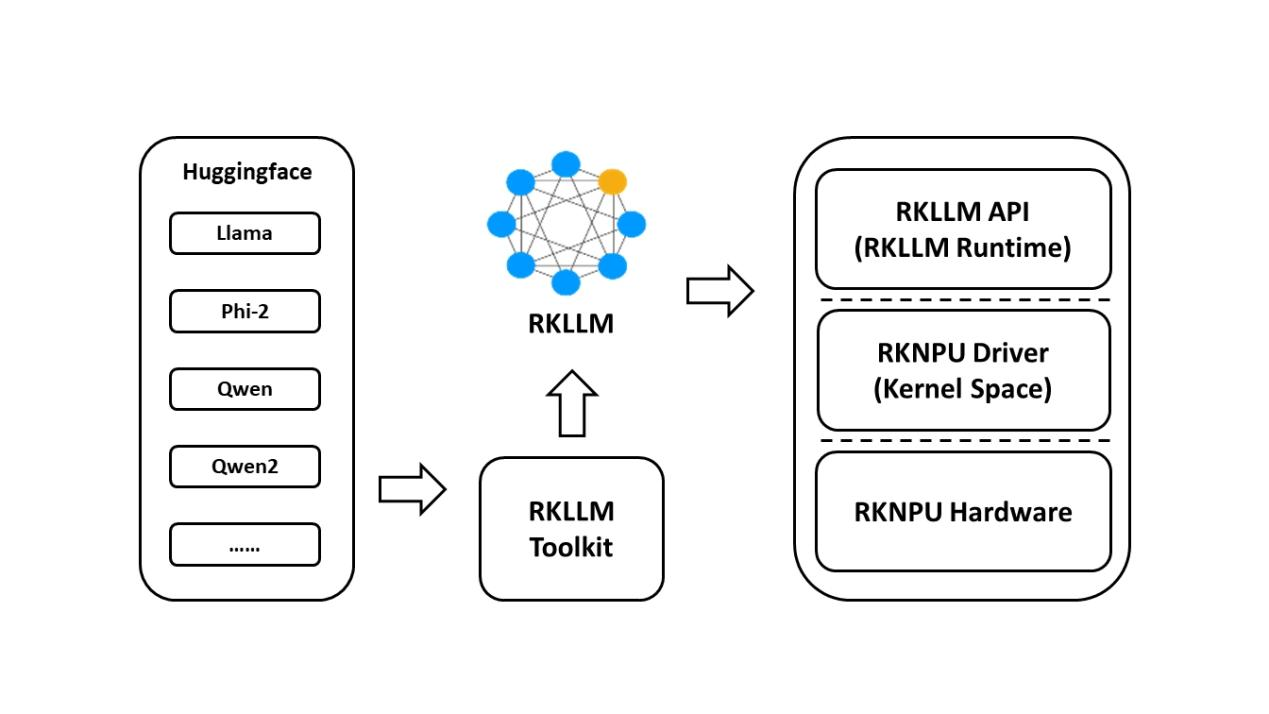

RKLLM-Toolkit 是为用户提供在计算机上进行大语言模型的量化、转换的开发套件,通过该工具提供的接口可以便捷的完成模型转换和模型量化。目前瑞芯微官方描述支持RK3588和RK3576,详情可在《RKLLM SDK User Guide》查找。

为了使用 RKNPU,用户需要首先在计算机上运行 RKLLM-Toolkit 工具,将训练好的模型转换成 RKLLM 格式的模型,然后使用 RKLLM C API 在开发板上进行推理。

RKLLM-Toolkit 是一款软件开发工具包,用于用户在 PC 上进行模型转换和量化。

RKLLM Runtime 为 Rockchip NPU 平台提供 C/C++ 编程接口,帮助用户部署 RKLLM 模型并加速 LLM 应用的实现。

RKNPU 内核驱动程序负责与 NPU 硬件交互。它已经开源,可以在 Rockchip 内核代码中找到。

二、安装miniforge3工具

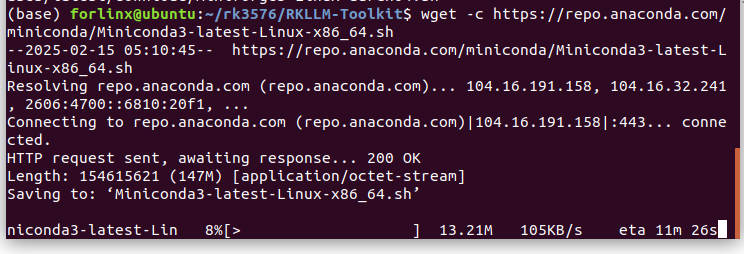

2.1、下载miniforge3安装包

Wget -c https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-x86_64.sh

或者使用下面的命令,下载源不同。

wget https://github.com/conda-forge/miniforge/releases/latest/download/Miniforge3-Linux-x86_64.sh

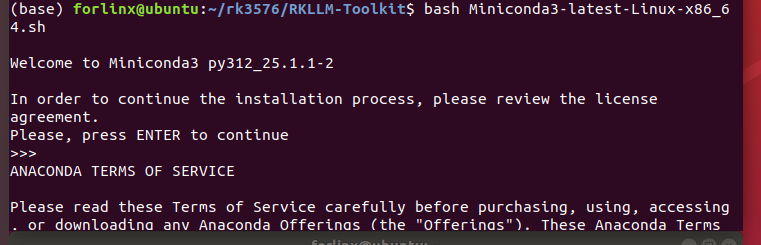

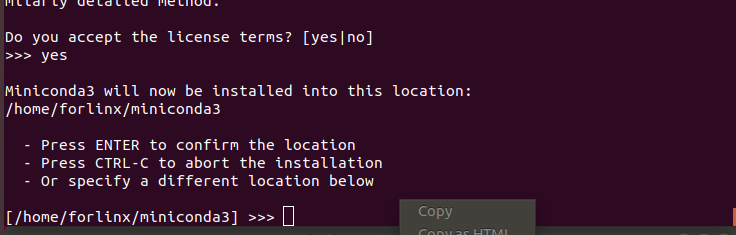

2.2、下载后安装Miniforget3软件

chmod 777 Miniforge3-Linux-x86_64.sh

bash Miniforge3-Linux-x86_64.sh

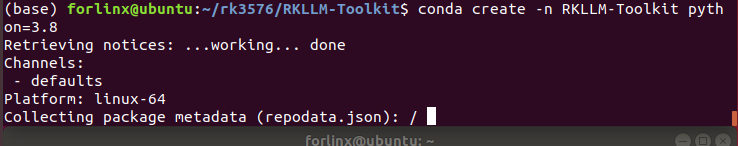

2.3、创建RKLLM-Toolkit Conda环境

设置下Conda base环境

source ~/miniforge3/bin/activate # miniforge3 为安装目录

创建一个 Python3.8 版本(建议版本)名为 RKLLM-Toolkit 的 Conda 环境

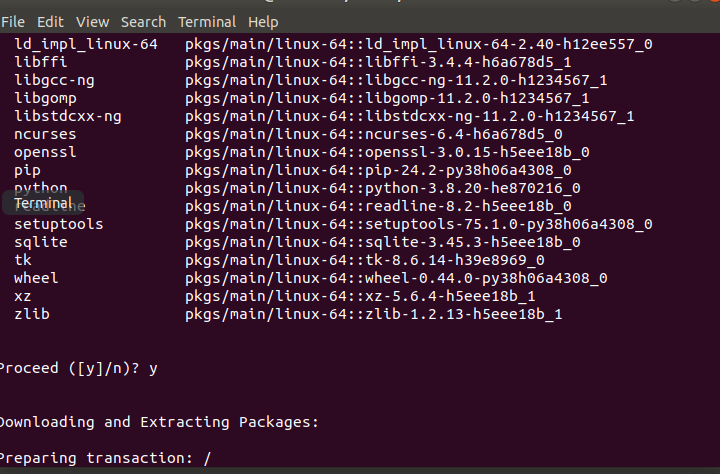

conda create -n RKLLM-Toolkit python=3.8

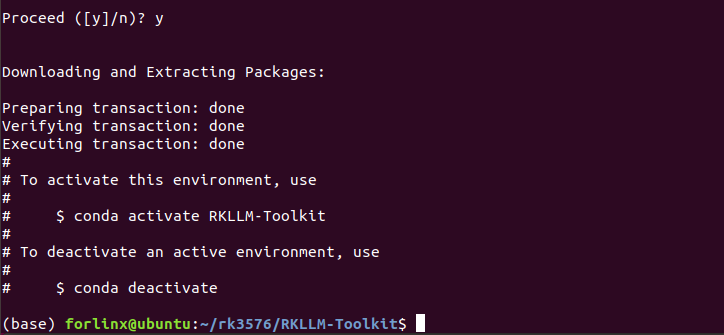

如上图所示,安装完成。

进入 RKLLM-Toolkit Conda 环境

conda activate RKLLM-Toolkit

三、安装 RKLLM-Toolkit

3.1、下载rknn-llm SDK

下载链接https://gitcode.com/gh_mirrors/rk/rknn-llm

解压后按照以下目录查找文件,rkllm_toolkit-x.x.x-cp38-cp38-linux_x86_64.whl

cd ~/rk3576/rknn-llm-main/rkllm-toolkit/

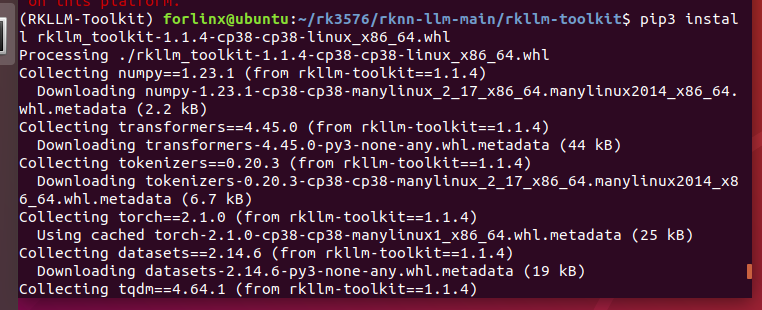

3.2、运行命令安装

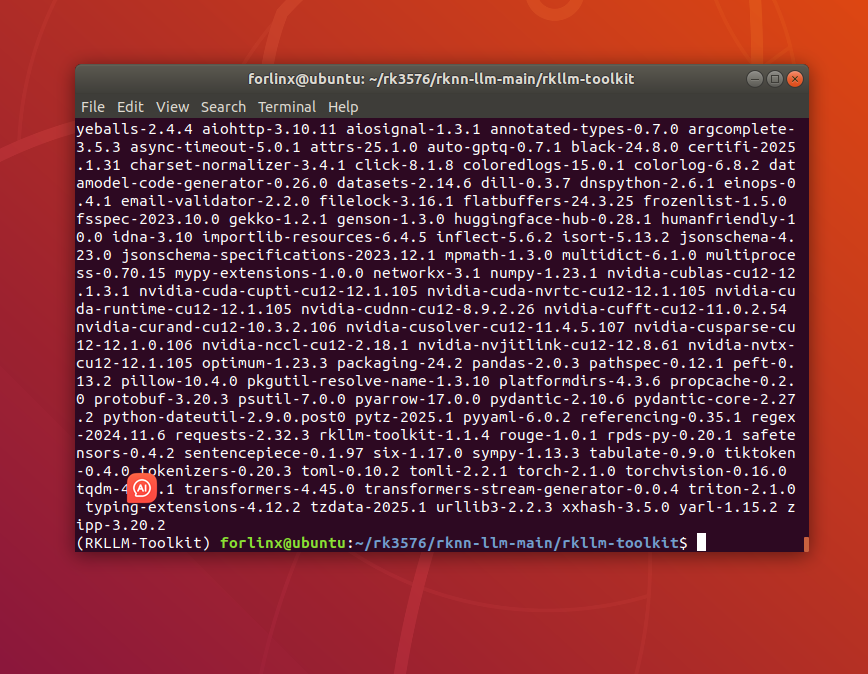

pip3 install rkllm_toolkit-1.1.4-cp38-cp38-linux_x86_64.whl

如果报错可以尝试以下命令:python -m pip install rkllm_toolkit-1.1.4-cp310-cp310-linux_x86_64.whl

还是不好使,更换了下软件源。https://mirrors.tuna.tsinghua.edu.cn/ubuntu/

历经十几次的报错终于是安装成功了,失败原因是因为网络

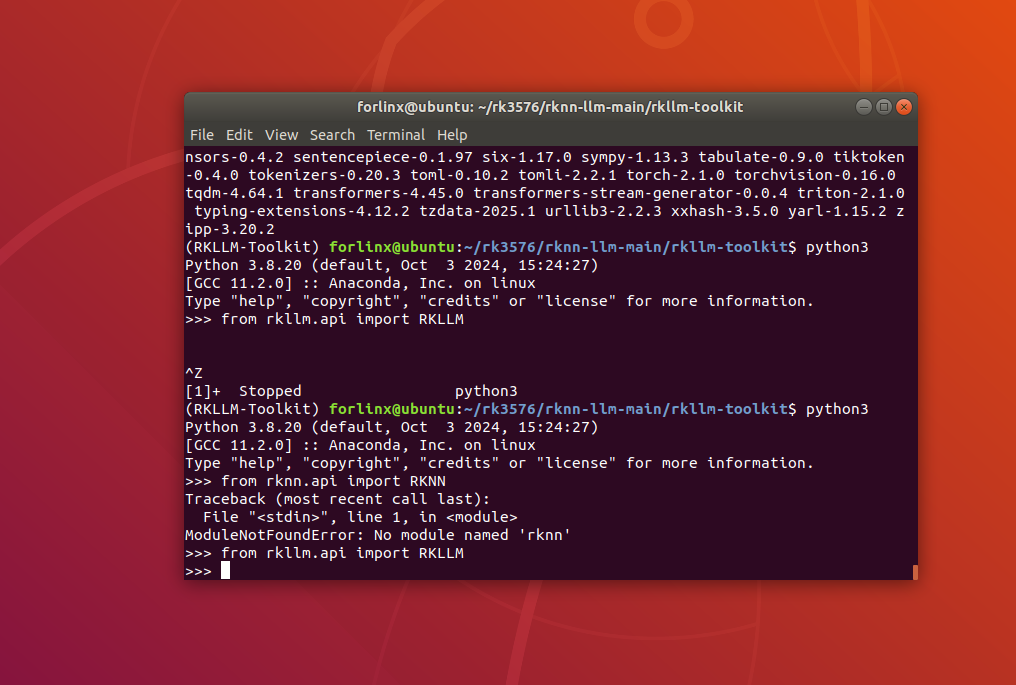

3.3、测试RKLLM

python

from rkllm.api import RKLLM

四、GCC工具软件安装

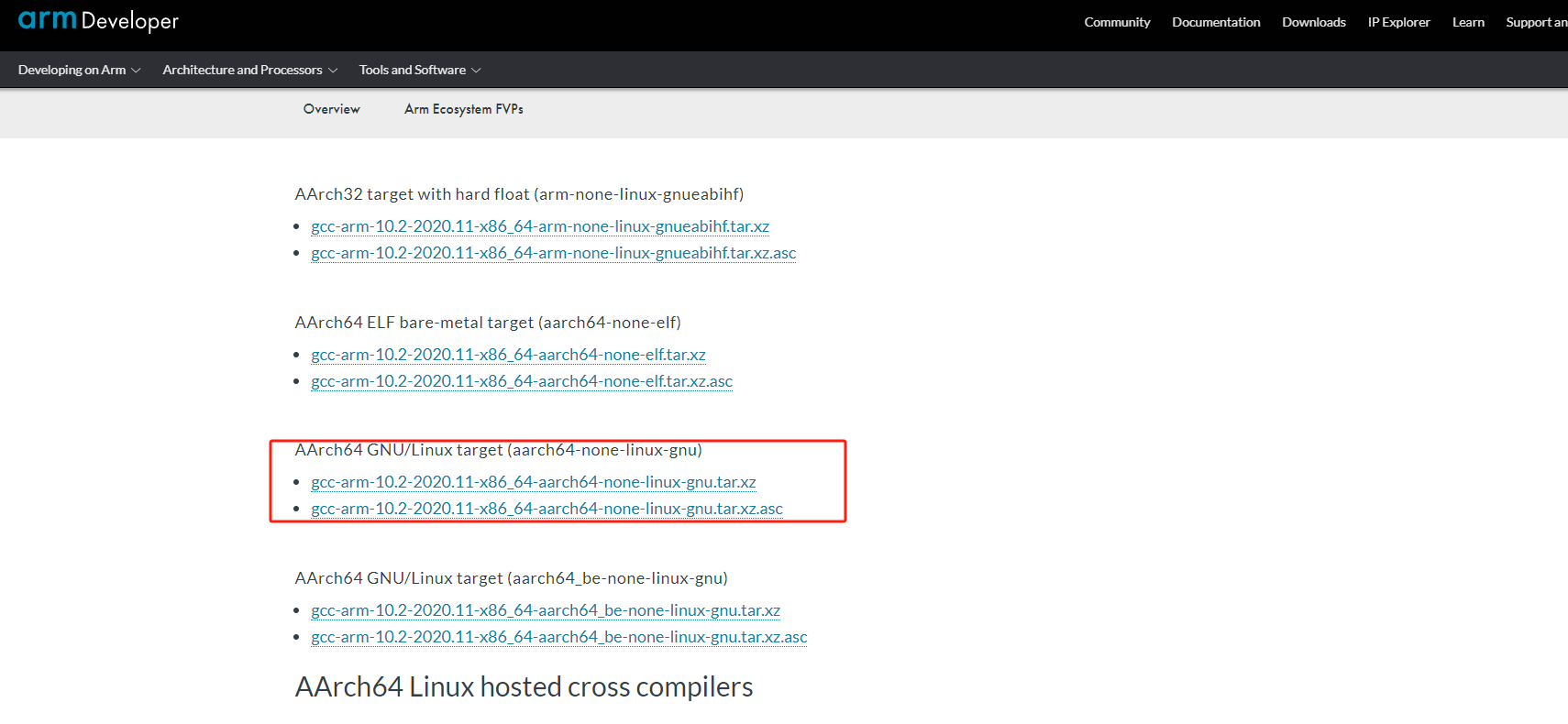

4.1、工具下载地址

https://developer.arm.com/downloads/-/gnu-a/10-2-2020-11

下载完之后,进行解压,加压后要记住工具的文件路径。

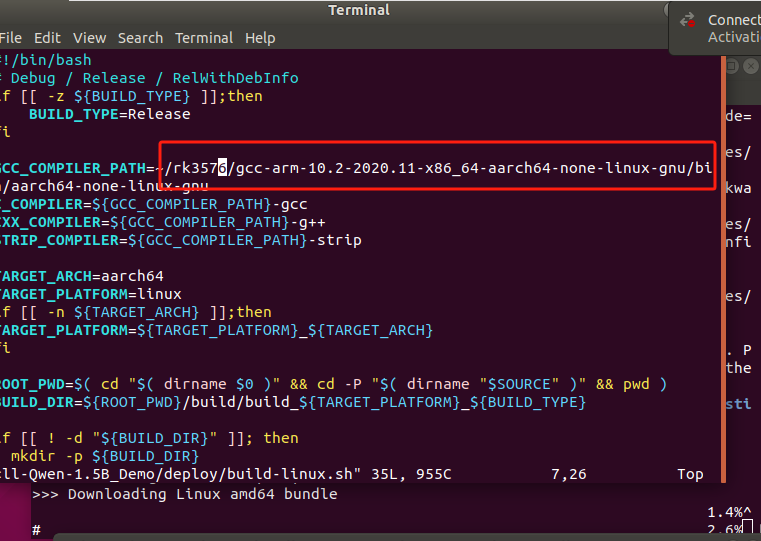

4.2、更改build-linux.Sh

更改PATH的工具路径如图所示:

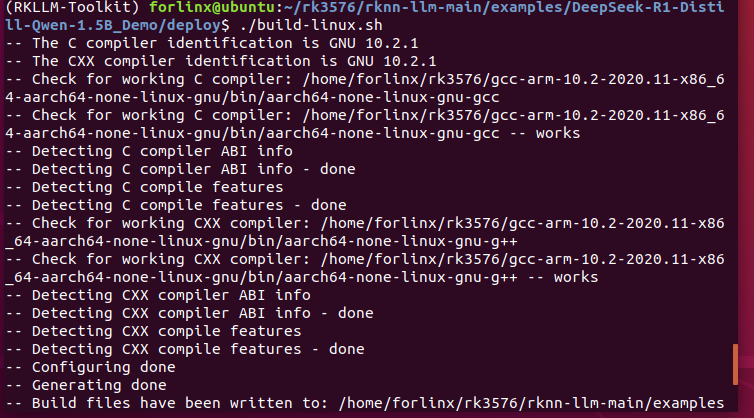

4.3、编译代码测试

五、安装OLLAMA工具

5.1、简介

Ollama 是一个开源的大模型服务工具,可以支持最新的deepseek模型,以及Llama 3,Phi 3,Mistral,Gemma 和其他多种模型,在安装Ollama工具之后,使用以下命令即可一键部署15亿参数的deepseek-r1模型,ollama其实就是AI届的Docker,所以使用起来也非常方便。

5.2、自动安装

同样受网络音响,因为源文件不在国内,自动安装很容易失败,然后我使用的是手动安装。

curl -fsSL https://ollama.com/install.sh | sh

手动安装,因为自动安装实在是太慢了。

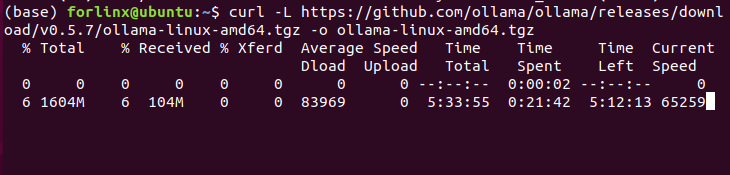

curl -L https://github.com/ollama/ollama/releases/download/v0.5.7/ollama-linux-amd64.tgz -o ollama-linux-amd64.tgz

sudo tar -C /usr -xzf ollama-linux-amd64.tgz

启动ollama

ollama serve

查看ollama版本

ollama -v

运行以下命令加载deepseek模型

ollama run deepseek-r1:1.5b

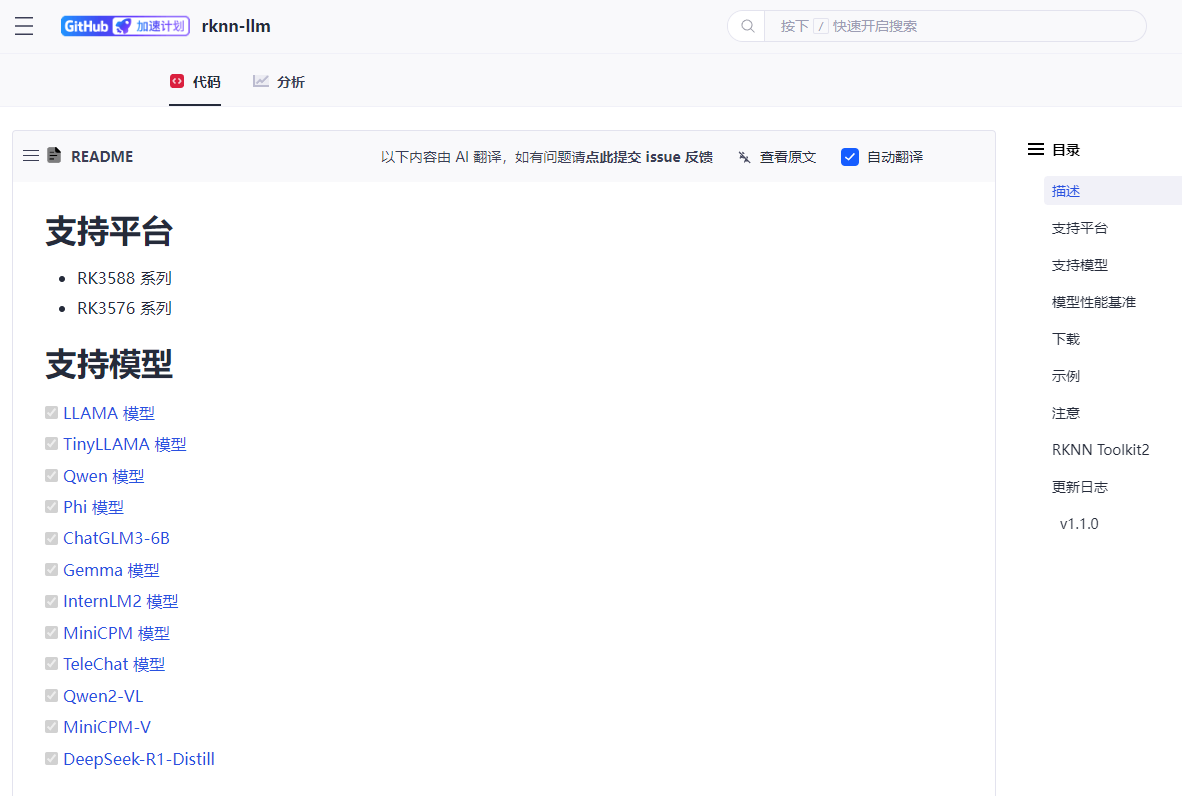

六、RKLLM支持模型

由于电脑内存原因,后面没有再继续实验测试。给大家整理了下环境安装的操作步骤。以后再实验RKLLM的开发与操作。

/6

/6